Ученье свет, а неученье тьма народная мудрость

| Вид материала | Документы |

СодержаниеGround Collision Avoidance System) Время реакции выбора — Психологический рефрактерный период — |

- Ученье свет, а неученье тьма народная мудрость, 3885.89kb.

- Каер Жанна Алексеевна моу вознесенская сош 10 класс сочинение, 63.71kb.

- «Ученье – свет, а неученье – тьма», 41.62kb.

- Внеклассное мероприятие по литературному чтению Долмашкина А. В.,Моу сош №44, 60.21kb.

- Задание Придумайте название для своей команды. Составьте небольшой рассказ о своей, 338.38kb.

- Ученье свет, а неученье жди проверки, 103.98kb.

- City of ember официальный дистрибьютор в России кинокомпания «Вест», 1964.97kb.

- Анхель де Куатьэ Тайна печатей (книги 1-6), 6473.48kb.

- Лекция 1-2, 1001.75kb.

- Говорят, нет дыма без огня, а, как известно, народная мудрость редко ошибается., 100.75kb.

95

96

возможным и фактическим количеством информации определяет далее так называемую избыточность системы событий. Избыточность является ничем иным, как мерой организации такой системы, степени ее отличия от совершенно случайного, хаотичного состояния. Важным источником избыточности в канале связи являются, наряду с абсолютной вероятностью возникновения событий, условные вероятности следования события друг за другом. Так, поскольку появление, а главное, следование отдельных фонем друг за другом в звуках человеческой речи далеко не равновероятны, общая избыточность системы фонем (или же букв при письме и чтении) естественных языков оказывается довольно большой, примерно равной 70%.

С инженерной точки зрения, можно говорить далее о различной степени оптимальности процессов кодирования информации. Оптимальным является такое кодирование событий, например в виде последовательностей двоичных символов «0» и «1», при котором более вероятные события будут представлены, более короткими цепочками символов. Интересно, что соответствующая эмпирическая зависимость — чем частотнее слово в языке, тем оно короче — действительно известна в лингвистике, где она называется «вторым законом Ципфа». При оптимальном кодировании канал связи, имеющий пропускную способность С бит/с, будет передавать С/Н двоичных символов в секунду. Если кодирование не оптимально, то фактическая скорость передачи информации уменьшится. Она в принципе никогда не может превзойти пропускную способность канала С, а тем более стать бесконечной (Яглом, Яглом, 1973).

Первой претеоретической метафорой будущей когнитивной психологии стало, таким образом, понимание человека как канала связи с ограниченной пропускной способностью. Это понимание буквально совпадало с тем специфическим аспектом рассмотрения возможностей человека, который был характерен для проводившихся еще в годы Второй мировой войны инженерно-психологических исследований. Поскольку экстремальные условия войны и начавшегося сразу после нее военно-индустриального соревнования Востока и Запада вновь и вновь обнаруживали специфические слабости человеческого звена в системе человек—машина, необходим был единый язык описания ограничений как техники, так и самого человека-оператора. Теория информации была воспринята многими психологами и инженерами как своего рода лапласовская «мировая формула» (см. 1.1.2), позволяющая единообразно описать возможности не только технических звеньев человеко-машинных систем, но и большое количество собственно психологических феноменов.

2.1.2 Инженерная психология и ее эволюция

В силу их значительного и продолжающегося влияния на когнитивный подход, нам следует хотя бы кратко остановиться здесь на особенностях и эволюции исследований «человеческого фактора» {human factor engineering), получивших в Западной Европе и СССР название инженерной психологии. Появление этой области исследований было вызвано целым рядом случаев отказа человеко-машинных систем, произошедших по вине человека. Один из наиболее драматических, хотя и малоизвестных эпизодов случился в декабре 1941 года на американской военно-морской базе Перл-Харбор, когда инженеры, обслуживавшие один из первых образцов только что поступивших на вооружение радиолокаторов, отчетливо увидели на экране отраженные от приближающихся японских самолетов сигналы, но просто не поверили, что такое количество сигналов возможно, и решили отправить аппаратуру на ремонт вместо того, чтобы сообщить в штаб флота о возможном нападении.

Потребовалось целое десятилетие, чтобы научиться аккуратно описывать подобные ситуации. Для этого инженерными психологами наряду с теорией информации стала использоваться заимствованная из радиотехники и психофизики теория обнаружения сигнала (Wald, 1950). Благодаря ряду допущений, эта теория позволила описать работу оператора в задачах на обнаружение с помощью всего лишь двух параметров: чувствительности (а") и критерия (β). Если первый параметр описывает сенсорные возможности различения сигнала на фоне шума, то второй, как мы сказали бы сегодня, связан именно с когнитивными переменными: представлением о вероятности появления сигнала, а также оценкой относительной «цены» последствий двух возможных и неизбежных в ситуации обнаружения ошибок — пропуска сигнала и ложных тревог. На основании этих когнитивных переменных формируется готовность оператора при прочих равных условиях подтверждать наличие сигнала (низкий, или либеральный критерий) либо воздерживаться от такого подтверждения (высокий, или консервативный критерий). С формальной точки зрения, именно завышенное положение критерия помешало операторам в Перл-Харборе подтвердить приближение воздушных целей.

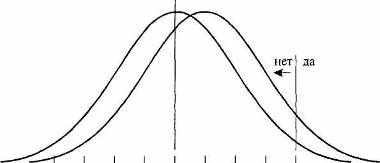

На рис. 2.1 показаны два идеализированных примера ситуации обна

ружения сигнала для простейшего случая, при котором появление сигна

ла не меняет разброса значений распределения шума, а просто сдвигает

это распределение вправо по оси величин регистрируемой в сенсорных

каналах активности. Распределение шума (аналог спонтанной сенсорной

активности) предполагается нормальным и стандартным, так что его сред

нее равно нулю, а стандартное отклонение — единице. Верхний график

описывает ситуацию обнаружения слабого сигнала, сдвигающего рас

пределение шума лишь на 0,5 его стандартного отклонения. Величина 0,5

и есть значение параметра чувствительности, обычно обозначаемого как

d' (произносится «дэ штрих»). Нижний график иллюстрирует обнаруже- „_

Ρ =2,0

сигнал и шум

шум

β

= 0,0 нет да

= 0,0 нет да  -2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0

-2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0d" сенсорное возбуждение

-2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0

-2,0 -1,5 -1,0 -0,5 0 0,5 1,0 1,5 2,0 а' сенсорное возбуждение

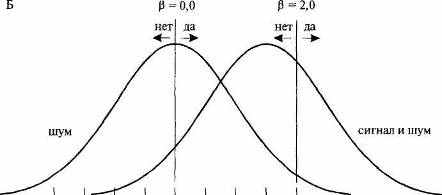

Рис. 2.1. Примеры использования аппарата теории обнаружения сигнала для описания ситуаций обнаружения слабого (А) и сильного (Б) сигналов на фоне шума.

98

ние более мощного сигнала. Расстояние между распределениями и, следовательно, чувствительность здесь больше: d' = 1,5. На обоих графиках также приведены по два возможных значения параметра критерия выбора ответа, β («бета»). Оператор, принимающий более низкий из этих двух критериев (β = 0,0), будет сообщать о появлении сигнала всякий раз, когда величина сенсорной активности превышает среднее для распределения шума значение. Критерий β = 2,0 означает, что о присутствии сигнала будет сообщаться, если величина сенсорной активности превысит два стандартных отклонения распределения шума.

Лейтмотивом множества исследований, проведенных с использованием аппарата теории обнаружения сигнала, стало представление о субоптимальности решений человека в ситуациях обнаружения. Особенно проблематичным оказалось постепенное ухудшение результатов обнаружения с увеличением времени наблюдения. Это ухудшение обычно состоит в ужесточении критерия принятия решений, что ведет к уменьшению числа ложных тревог, но чревато также и все более вероятными ошибками пропуска сигнала. Особенно яркими примерами этого явились сбои в обнаружении воздушных целей при охране наиболее важных государственных объектов системами противовоздушной обороны (ПВО) СССР и США в 1980-е годы. Так, в 1987 году немецкий летчик-любитель Маттиас Руст пересек со стороны Финляндии советскую границу, незамеченным долетел до Москвы и приземлился на Красной площади. Некоторое время спустя похожий инцидент произошел и в США, где недовольный налоговой политикой правительства фермер, захватив охотничье ружье, беспрепятственно долетел до центра Вашингтона, но разбился при попытке посадить свой самолет в саду Белого Дома. В обоих случаях операторы ПВО были «обезоружены» многолетним ожиданием вражеского нападения: стремясь избежать ложных тревог, они постепенно ужесточали критерии и в конце концов практически перестали замечать потенциально опасные цели.

О субоптимальности работы человека-оператора также говорили данные, собранные на основе экспертных оценок и представляемые в инженерной психологии в виде так называемых «МАВА—МAВА таблиц». Эти таблицы сравнивают между собой области деятельности и отдельные задачи, в которых человек оказывается лучше машины (Men-are-better-at) или, напротив, машина лучше человека (Machines-are-better-at). Так, задачи по обнаружению сигнала в силу колебаний внимания и отмеченной тенденции к завышению критерия принятия решений человеком лучше было бы доверить машине. С другой стороны, запоминание больших массивов информации и узнавание изображений первоначально считалось одной из областей, в которых человек был эффективнее машины. Разумеется, по мере развития компьютерных технологий количество таких областей стало постепенно сокращаться. Лишь наиболее сложные задачи, требующие глобальной оценки ситуации и выработки новых решений, причем часто на основании неполной информации, пока что прочно остаются в компетентности человека2.

2

Качество принимаемых человеком решений резко снижается в условиях стресса,

Качество принимаемых человеком решений резко снижается в условиях стресса,вызываемого в первую очередь недостатком времени. Поэтому, например, в современной

ядерной энергетике предпринимаются специальные меры для того, чтобы в течение 10—

20 минут фиксировать развитие событий, не давая человеку возможности реализовать

слишком поспешные решения. Подобные задержки «на обдумывание», к сожалению,

невозможны в работе летчика или водителя, где действовать часто приходится в интерва

лах времени порядка долей секунды (за 1 секунду автомобиль, движущийся со скоростью

60 км/час, проезжает около 17м). 99

К компетенции человека продолжают и, безусловно, будут продолжать относиться задачи по принятию решения в условиях многокатегориального выбора. В отличие от рассмотренной задачи обнаружения сигнала, где основания для решения могут быть представлены в виде одной-един-ственной переменной, в подобных задачах существует несколько качественно различных систем критериев и несколько (обычно более двух) альтернативных решений. Специфически человеческим звеном здесь является прежде всего оценка относительной важности (весовых коэффициентов) различных критериев. Такая оценка всегда довольно субъективна и не может быть сведена к одному критерию, даже такому существенному, как критерий стоимости. Например, если речь идет о выборе проекта нового предприятия, то наряду с критерием стоимости строительства (возможно, в сочетании с ожидаемыми доходами — критерий cost/ benefit) важную роль в том или ином контексте могут играть также и другие критерии, такие как критерии престижности или экологической безопасности. Сравнительную оценку важности критериев в каждом конкретном случае может дать только лицо (группа лиц), принимающее решение.

Помимо самой оценки специфическая сложность задач многокритериального выбора состоит в том, что «при их рассмотрении все доводы "за" и "против" не присутствуют в уме одновременно; иногда присутствует одна часть, в другое время — иная, причем первая исчезает из вида. Следовательно, различные цели или склонности по очереди берут "верх" и появляется неопределенность, которая озадачивает и мучает нас»3. В качестве простейшей исчерпывающей процедуры получения весовых коэффициентов отдельных критериев и их агрегации в общую оценку альтернатив в литературе по методам поддержки принятия решений (Ларичев, 2002) рекомендуется следующая последовательность шагов:

- Упорядочить критерии по важности.

- Присвоить наиболее важному критерию оценку 100 баллов и, ис

ходя из попарного отношения критериев по важности, дать в бал

лах оценку каждому из них.

- Сложить полученные баллы, а затем произвести нормировку кри

териев (вычислить их весовые коэффициенты), разделив присво

енные баллы на сумму весов.

- Оценить значение каждой альтернативы по каждому из критери

ев в отдельности по шкале от 0 до 100 баллов.

- Определить общую оценку каждой альтернативы, используя фор

мулу взвешенной суммы баллов (то есть просуммировать оценки

данной альтернативы по всем критерием с учетом весовых коэф

фициентов последних).

3

Эта цитата взята из письма Бенджамина Франклина, датированного сентябрем 1772 года. Франклин рекомендует далее записывать аргументы «за» и «против» на левой и правой стороне листа: «Когда я имею все это в поле зрения, я пытаюсь оценить их веса; если я найду два, каждый на другой стороне, которые кажутся мне равными, я их вычеркну... Если я считаю, что некоторые два довода "за" равны трем доводам "против", я вычеркиваю все пять; продолжая таким образом, я нахожу со временем, где находится баланс». Эти соображения можно считать эскизом современных компьютерных программ, поддерживающих процессы принятия решений (см. 8.4.2). Проблемы данной области связаны с нетранзитивным и нелинейным характером человеческих предпочтений, накладывающим ограни-100 чения на математические операции с балльными оценками (см. Ларичев, 2002).

Эта цитата взята из письма Бенджамина Франклина, датированного сентябрем 1772 года. Франклин рекомендует далее записывать аргументы «за» и «против» на левой и правой стороне листа: «Когда я имею все это в поле зрения, я пытаюсь оценить их веса; если я найду два, каждый на другой стороне, которые кажутся мне равными, я их вычеркну... Если я считаю, что некоторые два довода "за" равны трем доводам "против", я вычеркиваю все пять; продолжая таким образом, я нахожу со временем, где находится баланс». Эти соображения можно считать эскизом современных компьютерных программ, поддерживающих процессы принятия решений (см. 8.4.2). Проблемы данной области связаны с нетранзитивным и нелинейным характером человеческих предпочтений, накладывающим ограни-100 чения на математические операции с балльными оценками (см. Ларичев, 2002).6. Выбрать в качестве лучшей альтернативу, получившую наибольшую общую оценку.

Развернувшиеся во второй половине 20-го века работы по автоматизации отдельных функций и областей деятельности человека в целом проходили под лозунгом его освобождения от тяжелых и несвойственных ему сенсомоторных задач. Предполагалось, что за человеком-оператором постепенно останутся только функции когнитивного контроля за работой технических систем. С развитием информатики, электроники и когнитивных исследований стали создаваться системы относительно полного технического контроля и исполнения действий (такие как Flight Management Systems, используемые в военной и гражданской авиации для автоматического управления основными режимами полета). Постоянное увеличение степени сложности техники требовало от человека-пользователя сопоставимых, все более серьезных усилий по обучению и пониманию работы систем. Одновременно, из-за технических и финансовых ограничений автоматизации часто подвергались относительно изолированные фрагменты деятельности.

Результаты подобной фрагментарной замены человека компьютерными системами часто оказывались неудовлетворительными. В этих полуавтоматизированных системах скорее сам человек оказался под контролем автоматов, чем наоборот. Известный отечественный инженерный психолог Б.Ф. Ломов (например, Ломов, 1966) еще в начале 1960-х годов предупреждал об опасности такого развития, выдвинув вместе со своими коллегами принцип «активного оператора». Главным недостатком, или, по словам современной английской исследовательницы Лизанн Бэйнб-ридж, иронией автоматизации стало сегодня то, что оператору или, например, летчику временами приходится действовать в еще более экстремальном диапазоне нагрузок, чем прежде. Относительно легкие задачи упростились за счет их автоматизации, тогда как трудные задачи стали более сложными в силу усложнения самих человеко-машинных систем, а также из-за того, что решать их приходится внезапно и из состояния недонагрузки. При внезапных повышенных нагрузках в условиях жестких временных ограничений возникает состояние острого стресса, меняющее протекание практически всех познавательных процессов. Стресс, в частности, ведет к эффекту так называемого туннельного зрения — резкому ограничению размеров функционального поля зрения и фиксации внимания на отдельных деталях, а не на сцене в целом (см. 4.2.2 и 9.4.3).

Центральной проблемой сегодня становится выравнивание этого дисбаланса, то есть избирательная поддержка (вплоть до полной замены4)

4

Речь идет о временной передаче управления автоматам. Примером могут служить

Речь идет о временной передаче управления автоматам. Примером могут служитьсовременные системы предотвращения столкновения с земной поверхностью (GCAS —

Ground Collision Avoidance System), используемые в военной авиации. Эти системы оцени

вают параметры движения самолета и с учетом рельефа местности, а также времени реак

ции пилота автоматически уводят самолет в случае необходимости из опасной зоны. 101

человека в тех случаях, когда он находится на пределе своих возможностей, и, напротив, эпизодическая передача ему дополнительных функций (например, ручного управления самолетом) в периоды потенциально опасной недонагрузки. В результате возникает новая задача адаптивной автоматизации. Она предполагает психологический мониторинг функционального состояния человека с текущей оценкой степени и характера его внимания, содержаний восприятия, понимания актуальной ситуации (или «осознания ситуации» — situation awareness) и, насколько возможно, также непосредственных намерений. Хотя в общем виде эта задача еще очень долго не будет иметь решения, ее частные решения, похоже, возможны; они опираются на результаты прикладных когнитивных исследований и также обсуждаются на страницах этой книги (см. 3.4.2 и 7.4.3).

Инженерную психологию всегда интересовала задача нахождения некоторого единого языка для описания работы человека и функционирования технических систем. Наиболее подходящим языком такого описания вначале считалась теория информации. С накоплением опровергающих это мнение данных (см. 2.1.3), а затем и с возникновением задачи адаптивной автоматизации стали меняться акценты, так что иногда сами машины стали описываться в антропоморфных терминах как продукты (артефакты) деятельности человека. Так, датчанин Йене Расмуссен (Rasmussen, 1986) предложил рассматривать все компоненты человеко-машинных систем в контексте трех, известных из теории деятельности вопросов: «для чего?», «что?» и «как?» (см. 1.4.3). Им же была предложена трехуровневая модель операторской деятельности, в которой на самом низком уровне поведение находится под контролем автоматизированных навыков, на втором — хранящихся в памяти правил и на третьем — знаний о ситуации. Данная модель используется прежде всего для классификации ошибок оператора. В зависимости от уровня возникновения такие ошибки влекут за собой разную степень ответственности. Например, авиадиспетчер может просто перепутать похожие команды (неудачно расположенные рядом кнопки) или же, подумав, сознательно направить два самолета на одну и ту же посадочную полосу (см. 9.1.3).

Недостатком этой и аналогичных ранних моделей является то, что они были совершенно недостаточно обоснованы с точки зрения фундаментальных исследований. В частности, их авторы полностью игнорировали нейрофизиологические и нейропсихологические данные, столь важные, как становится очевидно в последние годы, для создания более реалистических представлений о специфических особенностях и ограничениях возможностей человека в его взаимодействии с техническими системами (см. 7.4.3 и 8.4.3). Эти данные впервые заложили теоретико-экспериментальную основу для прикладных исследований на границе психологии и новых технологий, подтверждая старое правило «Нет ни-102 чего практичнее хорошей теории». Кроме того, классическая для этой

области проблематика стресса и утомления обусловила постоянный диалог исследований когнитивной организации с анализом функциональных состояний (см. 9.4.3). Таким образом, развитие инженерной психологии и такого нового ее раздела, как когнитивная эргономика (дисциплина, занимающаяся оптимизацией взаимодействия человека и компьютерных систем), сегодня находится под прямым влиянием исследований в широкой области когнитивных и аффективных нейронаук.

2.1.3 Поиски ограничений пропускной способности

Вернемся к ситуации, в которой оказались исследования познавательных процессов в 1950-е годы. Основные экспериментальные работы этого периода имели прикладной характер и были направлены на возможно более точное описание ограничений информационной пропускной способности человека. К числу основных феноменов, иллюстрирующих такие ограничения, обычно относят следующие:

- Время реакции выбора — замедление времени реакции с увеличени

ем числа альтернатив.

- Избирательность (селективность) внимания — невозможность од

новременно и в равной степени следить за содержанием двух раз

личных сообщений.

- Колебание внимания — невозможность в течение сколько-нибудь

продолжительного времени с одинаковой «бдительностью» (vigi

lance) следить, скажем, за экраном радиолокатора.

- Объем непосредственной памяти — невозможность запомнить после

однократного предъявления более чем 5—7 не связанных между со

бой объектов или символов.

- Психологический рефрактерный период — задержка реакции на вто

ром из двух следующих друг за другом с достаточно малым интер

валом (менее 150 мс) стимулов.

В последующих главах эти феномены будут рассмотрены нами в контексте современных представлений о возможных ограничениях познавательных процессов. Мы остановимся здесь подробно на самом первом в списке этих феноменов. Еще в 1885 году один из учеников Вундта Меркель установил, что время реакции выбора («В-реакция» Дондерса: η стимулов и « реакций) линейно зависит от логарифма числа стимулов. Этот же результат был получен почти 70 лет спустя американцами Хиком и Хэйменом, которые объяснили его как следствие зависимости времени реакции от количества средней информации:

ВР = а+ в*Н,

где а — параметр, задаваемый временем передачи информации на входе и выходе канала; в — величина, обратная пропускной способности канала, и Η — среднее количество информации, определяемое по формулам, приведенным в начале этой главы. Это соотношение, получившее ЮЗ

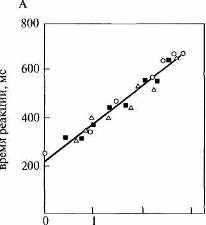

название закона Хика, сохраняется при различных способах варьирования средней информации: изменении числа альтернатив, изменении абсолютных вероятностей при постоянном числе альтернатив и, наконец, введении различных вероятностей следования одних сигналов за другими (рис. 2.2А).

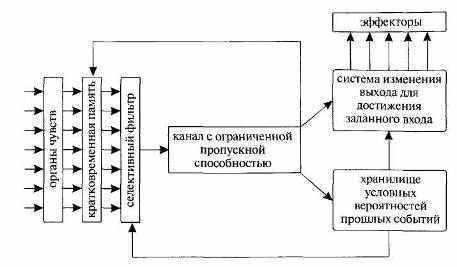

В рамках инженерно-психологических исследований ограничений избирательного внимания и непосредственной памяти Дональд Брод-бент (ученик Бартлетта и бывший военный летчик, участвовавший в воздушной битве за Англию) опубликовал в 1954 году статью под названием «Механическая модель внимания и непосредственной памяти человека», где впервые описал внимание как фильтр, осуществляющий отбор релевантной с точки зрения задачи сенсорной информации. Этот фильтр расположен на входе в непосредственную память — «центральный информационный канал с ограниченной пропускной способностью» — и осуществляет отбор релевантной информации по принципу «все или ничего» (рис. 2.3). Близкие идеи легли в основу монографии Бродбента «Восприятие и коммуникация», вышедшей в свет в 1958 году. В этой работе был обобщен гигантский объем данных, полученный в рамках информационного подхода. Это развитие целиком соответствовало неопозитивистским канонам — как и в необихевиоризме автором проводился формальный анализ наблюдаемых переменных, а человек трактовался как относительно закрытый «черный ящик». Очерки психологии с точки зрения статистической теории связи появились в конце 1950 — начале 1960-х годов. Однако это было время, когда информационный подход стал подвергаться серьезной критике.

2 3 0 1

количество информации, бит

Рис. 2.2. Закон Хика — зависимость времени реакции выбора от информативности сиг-104 налов: А. Первоначальные данные; Б. Данные, собранные за последующие 10 лет.

Рис. 2.3. Одна из первых информационных моделей памяти и внимания, предложенная Бродбентом (Broadbent, 1958).

Прежде всего, установленные законы стали обрастать дополнениями и оговорками, учитывающими субъективную значимость и естественность различных ситуаций. Так, едва ли не центральной проблемой инженерной психологии в эти годы стала проблема естественного соответствия сигналов и ответов испытуемого: время реакции ускоряется, если, например, на акустический сигнал, подаваемый справа, нужно отвечать правой рукой. Разумеется, этот эффект можно попытаться объяснить строго физикалистски, проследив движение информации по нейрофизиологическим путям — от правого уха в контрлатеральное левое полушарие, которое, в свою очередь, иннервирует преимущественно правую часть тела. Однако такое объяснение может быть легко поставлено под сомнение. Если попросить испытуемого скрестить руки, то на сигналы, поступающие справа, он начинает быстрее отвечать левой рукой. Существенной, таким образом, оказывается близость сигналов и ответов в феноменальном, а не физическом пространстве5. Встает типичный для собственно когнитивной психологии вопрос о форме репрезентации — о том, каким образом могут быть внутренне представлены внешнее окружение, сигналы и схема тела.

Исследования времени реакции выбора постепенно выявили чрезвычайно пеструю картину, совершенно не укладывающуюся в прокрус-

5 Надо сказать, что подчеркивание роли таких переменных, как значимость и естественность, типично как раз для «аристотелевского», а не «галилеевского» способа образования понятия (см. 1.3.1).

5 Надо сказать, что подчеркивание роли таких переменных, как значимость и естественность, типично как раз для «аристотелевского», а не «галилеевского» способа образования понятия (см. 1.3.1).105