Кафедра «Автоматизированные системы обработки информации и управления» доклад по дисциплине «Современные проблемы информатики и вычислительной техники» проблемы искусственного интеллекта

| Вид материала | Доклад |

- Рабочая программа По дисциплине «Системы искусственного интеллекта» для специальности, 86.74kb.

- Программа дисциплины сд. Ф системы искусственного интеллекта для студентов специальности, 295.9kb.

- Рабочая программа дисциплины «Архитектура ЭВМ и вычислительных сетей» для специальности, 325.46kb.

- Рабочая программа По дисциплине «Средства взаимодействия человека с вычислительной, 226.84kb.

- План занятий второго года обучения, по специальностям, 95.99kb.

- Рабочая программа дисциплины «Системы искусственного интеллекта» по направлению подготовки, 132.28kb.

- Рабочая программа по дисциплине «Математическая логика и теория алгоритмов» для специальности, 67.42kb.

- Рабочая программа дисциплины «Автоматизированные информационные системы» для специальности, 301.29kb.

- Рабочая программа дисциплины «Автоматизированные системы обработки экономической информации», 306.21kb.

- Рабочая программа по дисциплине правоведение для специальностей: 080503, 194.58kb.

Федеральное агентство по образованию

ГОСУДАРСТВЕННОЕ ОБРАЗОВАТЕЛЬНОЕ УЧРЕЖДЕНИЕ ВЫСШЕГО ПРОФЕССИОНАЛЬНОГО ОБРАЗОВАНИЯ «ОМСКИЙ ГОСУДАРСТВЕННЫЙ ТЕХНИЧЕСКИЙ УНИВЕРСИТЕТ» (ОмГТУ)

Кафедра «Автоматизированные системы обработки информации и управления»

ДОКЛАД

по дисциплине «Современные проблемы информатики и вычислительной техники»

ПРОБЛЕМЫ ИСКУССТВЕННОГО ИНТЕЛЛЕКТА

Принял:

к.т.н, доц. каф АСОИУ Задорожный В.Н.

подпись, дата

Выполнил:

студент гр. РАС-518 Сосняков С.И.

подпись, дата

Омск 2008

Содержание

Введение 3

1 Определение искусственного интеллекта 4

2 Пределы роста вычислительной системы 5

3 Алгоритмически неразрешимые задачи 6

4 Неполнота и неразрешимость формальных систем 8

Заключение 10

Введение

Можно ли считать, что механическое устройство в принципе способно мыслить, или даже испытывать определенные чувства? Этот вопрос не нов, но с появлением современных компьютерных технологий он приобрел новое значение. Смысл вопроса глубоко философский. Что значит — думать или чувствовать? Что есть сознание? Существует ли оно объективно? И если да, то в какой степени он функционально зависимо от физических структур, с которыми его ассоциируют? Может ли оно существовать независимо от этих структур? Или оно есть лишь продукт деятельности физической структуры определенного вида? В любом случае – должны ли подходящие структуры быть обязательно биологическими или, возможно, этими структурами могут быть и электронные устройства? Подчиняется ли разум законам физики?

Таким образом, видно, что само понятие интеллекта не определено до конца. При этом существует ряд проблем, которые препятствует созданию компьютера, способного мыслить как человек. Некоторые из этих проблем будут рассмотрены в данном докладе.

1 Определение искусственного интеллекта

Представите, что появилась новая модель очень мощного компьютера, вычислительные возможности которого много превосходят возможности человека. При этом разработчики уверяют, что он корректно запрограммирован, обладает огромным количеством данных, и, главное, разработчики утверждают, что он может мыслить. Как нам понять, можно ли верить производителю или нет? Можно принять, что компьютер мыслит, если он ведет себя, так же как и человек в момент раздумий. Естественно, мы от него не можем потребовать, чтобы он расхаживал по комнате, как мог бы себя вести размышляющий о чем-то человек. Более того, даже не важно, чтобы компьютер внешне напоминал человека: эти качества не имеют отношения к назначению компьютера. Главное – это способность выдавать схожие с человеческими ответы на любой вопрос. Этот подход отстаивается в статье Алана Тьюринга «Вычислительные машины и интеллект».

В этой статье впервые была предложена идея того, что сейчас называют тестом Тьюринга. Тест предназначался для ответа на вопрос о том, можно ли резонно утверждать, что машина думает. Пусть утверждается, что некоторый компьютер в действительности думает. Для проведения теста Тьюринга компьютер вместе с человеком добровольцем скрывают от глаз опрашивающего. Опрашивающий должен попытаться определить, где компьютер, а где человек, задавая им двоим пробные вопросы. Вопросы, а еще важнее – ответы, которые она получает, передаются в безличной форме, например, печатаются на клавиатуре и высвечиваются на экране. Единственная информация, которой будет располагать опрашивающий – это то, что он сам сможет выяснить в процессе такого сеанса вопросов и ответов. Опрашиваемый человек честно отвечает на все вопросы, пытаясь убедить судью, что он и есть живое существо; компьютер, однако, запрограммирован таким образом, чтобы обмануть опрашивающего и убедить его в том, что человек на самом деле он. Если в серии подобных тестов опрашивающий окажется неспособным «вычислить» компьютер никаким последовательным образом, то считается, что компьютер прошел данный тест.

В 1990 году был учрежден конкурс Хью Лебнера, который заключается в соревновании систем искусственного интеллекта на прохождение теста Тьюринга. Главный приз состязания – $100000 и золотая медаль – должны достаться создателю первой искусственной системы, которая сможет пройти тест Тьюринга на наличие разума. До настоящего времени пройти тест Алана Тьюринга и получить главный приз Хью Лебнера не удалось никому. Премия в $2000 и бронзовая медаль ежегодно присуждается авторам наиболее "человекоподобной" системы искусственного интеллекта.

Однако, прохождение машиной теста Тьюринга не означает, что данная машина разумна. Опровержение адекватности теста Тьюринга было предложено Джоном Серлем. Джон Серль предложил следующий мысленный эксперимент.

Возьмем человека, который не знает китайского языка и поместим его в комнату, в которой расставлены корзинки, полные китайских иероглифов. Предположим также, что ему дали учебник, в котором приводятся правила сочетания символов китайского языка, причем правила эти можно применять, зная лишь форму символов, понимать значение символов совсем необязательно. Например, правила могут гласить: «Возьмите такой-то иероглиф из корзинки номер один и поместите его рядом с таким-то иероглифом из корзинки номер два».

Представим себе, что находящиеся за дверью комнаты люди, понимающие китайский язык, передают в комнату наборы символов и что в ответ я манипулирую символами согласно правилам и передаю обратно другие наборы символов. В данном случае книга правил есть не что иное, как «компьютерная программа». Люди, написавшие ее, — «программисты», а человек играет роль «компьютера». Корзинки, наполненные символами, — это «база данных»; наборы символов, передаваемых в комнату, это «вопросы», а наборы, выходящие из комнаты, это «ответы».

Предположим далее, что книга правил написана так, что мои «ответы» на «вопросы» не отличаются от ответов человека, свободно владеющего китайским языком. Например, люди, находящиеся снаружи, могут передать непонятные мне символы, означающие: «Какой цвет вам больше всего нравится?». В ответ, выполнив предписанные правилами манипуляции, человек выдаст символы также ему непонятные и означающие, что его любимый цвет синий, но ему также очень нравится зеленый. Таким образом, он выдержу тест Тьюринга на понимание китайского языка. Но все же на самом деле этот человек не понимает ни слова по-китайски. К тому же он никак не может научиться этому языку в рассматриваемой системе, поскольку не существует никакого способа, с помощью которого можно было бы узнать смысл хотя бы одного символа. Подобно компьютеру, человек манипулирует символами, но не может придать им какого бы то ни было смысла.

Сущность этого мысленного эксперимента состоит в следующем: если человек не может понять китайского языка только потому, что выполняет компьютерную программу для понимания китайского, то и никакой другой цифровой компьютер не сможет его понять таким образом. Цифровые компьютеры просто манипулируют формальными символами согласно правилам, зафиксированным в программе.

То, что касается китайского языка, можно сказать и о других формах знания. Одного умения манипулировать символами еще недостаточно, чтобы гарантировать знание, восприятие, понимание, мышление и т. д. И поскольку компьютеры как таковые – это устройства, манипулирующие символами, наличия компьютерной программы недостаточно, чтобы можно было говорить о наличии знания.

2 Пределы роста вычислительной системы

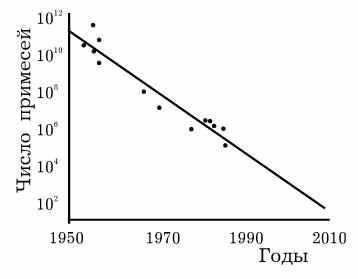

В 1975г. один из основателей Intel Г. Мур сделал прогноз о том, что количество транзисторов на кристалле процессора будет увеличиваться в два раза каждые 18 месяцев. Несмотря на свой фантастический характер, этот прогноз сбывается в течение 30 лет. Размеры элементов процессора уменьшаются и уменьшаются. На рис. 6.1 представлен график зависимости числа примесей в основаниях транзисторов от времени (можно считать, что этот график показывает количество электронов, необходимых для хранения одного бита информации).

Рисунок 1 – Зависимость числа примесей в основаниях транзисторов от времени

Из графика видно, что, если на заре компьютерной эры было необходимо 1011 электронов для хранения одного бита информации, то сегодня это уже около 104. По словам того же Г. Мура, мы приближаемся к технологическому пределу, который не позволит в дальнейшем уменьшать размеры элементной базы. Предел этот составляет 30 нм.

С другой стороны, как утверждают специалисты по параллельным вычислениям на основе сравнения двух процессоров – EDSAC и PA-8700, за счет усовершенствования технологии (уменьшения процессорных элементов) производительность компьютеров повысилась в 1500 раз, а за счет усовершенствования архитектуры, в частности применения элементов параллелизма – в 1 000 000 раз.

Самый мощный компьютер на сегодня – это BlueGene/L, содержащий 32768 процессоров Power 4. Его пиковая производительность - 91750 ГФлопс, максимальная, достигнутая на тесте Linpack: 70720 ГФлопс. Несмотря на наличие столь мощных вычислительных систем, мы не умеем решать многих необходимых задач, с которыми справляются системы обработки информации в клетках.

Можно предположить, что в ближайшем будущем рост производительности вычислительных систем за счет уменьшения элементов процессора остановится. Естественно, рост может продолжиться за счет развития архитектуры. Однако, для множества задач, которые имеют экспоненциальную сложность, рост производительности не гарантирует получения решений. При этом вполне возможно, что алгоритм, реализующий возможности интеллекта относится к числу трудоемких.

Необходимо отметить, что квантовые компьютеры, которые только разрабатываются, способны решать экспоненциальные задачи за полиномиальное время.

Но несмотря на это самый совершенный компьютер не может выполнять более чем 1047 битовых операций в секунду, то есть не может превзойти предел Бремермана-Эшби.

3 Алгоритмически неразрешимые задачи

За время своего существования человечество придумало множество алгоритмов для решения разнообразных практических и научных проблем. Зададимся вопросом – а существуют ли какие-нибудь проблемы, для которых невозможно придумать алгоритмы их решения?

Утверждение о существовании алгоритмически неразрешимых проблем является весьма сильным – мы констатируем, что мы не только сейчас на знаем соответствующего алгоритма, но мы не можем принципиально никогда его найти.

Успехи математики к концу XIX века привели к формированию мнения, которое выразил Д. Гильберт – «в математике не может быть неразрешимых проблем», в связи с этим формулировка проблем Гильбертом на конгрессе 1900 года в Париже была руководством к действию, констатацией отсутствия решений в данный момент.

Первой фундаментальной теоретической работой, связанной с доказательством алгоритмической неразрешимости, была работа Курта Гёделя – его известная теорема о неполноте символических логик. Это была строго формулированная математическая проблема, для которой не существует решающего ее алгоритма. Усилиями различных исследователей список алгоритмически неразрешимых проблем был значительно расширен.

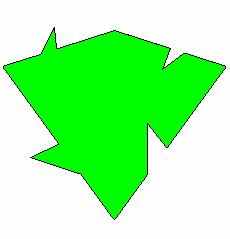

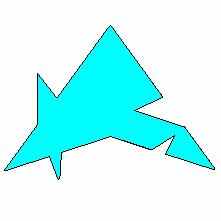

Примером алгоритмически неразрешимой задачи является задача об отыскании набора геометрических фигур на плоскости, которыми Евклидова плоскость может быть покрыта только непериодическим образом. В 1961 г. было показано, что невозможно создать алгоритм, который определяет, можно ли покрыть плоскость при помощи заданного набора плиток, или нет. Позже был предъявлен набор из 20426 плиток, которыми можно покрыть плоскость только непериодически. В дальнейшем количество плиток было сокращено сначала до 104, а затем и до 6, и, наконец, до двух (рисунок 2).

Рисунок 2 – Плитки Пенроуза, которыми плоскость может быть заполнена только непериодическим образом

Это решение было получено Пенроузом путем различных манипуляций разрезания и склеивания над набором Робинсона из 6 плиток.

Решение задачи о покрытии плоскости плитками непериодическим образом служит подтверждением гипотезы Пенроуза о невычислимости сознания. Под невычислимостью в данном контексте понимается принципиальная невозможность предъявить машину Тьюринга для решения конкретной задачи.

Еще одной важной гипотезой Пенроуза стала гипотеза об объективной квантовой редукции: существует некоторый объективный физический процесс, который воздействует на редукцию квантового состояния. Проектируется эксперимент в космических масштабах, который позволит проверить эту гипотезу. Однако существует гипотеза C. Хамероффа о том, что объективная редукция играет важную роль и в механизмах работы сознания, в процессах, происходящих в наномасштабе во внутренних структурах клетки. Из гипотезы С. Хамероффа вытекает то, что клетка – это квантовый компьютер. В своих работах Хамерофф предлагает схему квантового вычислителя, основанного на механизме объективной редукции и переключениях между конформациями тубулинов.

4 Неполнота и неразрешимость формальных систем

На рубеже XIX и ХХ столетий в теории множеств были обнаружены противоречия, для обозначения которых был придуман эвфемизм «парадоксы теории множеств». Наиболее известный из них — знаменитый парадокс Рассела — был не единственным. Более того, для большинства ученых было очевидно, что за открытием новых странностей дело не станет. Их появление оказало на математический мир, по выражению Гильберта, «катастрофическое воздействие», поскольку теория множеств играла роль фундамента, на котором возводилось все здание науки о числах.

Таким образом, впервые за три тысячелетия математики вплотную подошли к изучению самых глубинных оснований своей дисциплины. Сложилась любопытная картина: любители цифр научились четко объяснять, по каким правилам они ведут свои вычисления, им оставалось лишь доказать «законность» принятых ими оснований с тем, чтобы исключить любые сомнения, порождаемыме злополучными парадоксами. И в первой половине 20-х гг. великий Гильберт, вокруг которого сложилась к тому времени школа блестящих последователей, в целой серии работ наметил план исследований в области оснований математики, получивший впоследствии название «Геттингенской программы». В максимально упрощенном виде ее можно изложить следующим образом: математику можно представить в виде набора следствий, выводимых из некоторой системы аксиом, и доказать, что:

- математика является полной, т.е. любое математическое утверждение можно доказать или опровергнуть, основываясь на правилах самой дисциплины.

- математика является непротиворечивой, т.е. нельзя доказать и одновременно опровергнуть какое-либо утверждение, не нарушая принятых правил рассуждения.

- математика является разрешимой, т.е., пользуясь правилами, можно выяснить относительно любого математического утверждения, доказуемо оно или опровержимо.

Фактически программа Гильберта стремилась выработать некую общую процедуру для ответа на все математические вопросы или хотя бы доказать существование таковой. Сам ученый был уверен в утвердительном ответе на все три сформулированные им вопроса: по его мнению, математика действительно была полной, непротиворечивой и разрешимой. Оставалось только это доказать.

Однако в 1930 г. на конференции, организованной «Венским кружком» в Кенигсберге, американский математик Курт Гедель сделал доклад «О полноте логического исчисления», а в начале следующего года опубликовал статью «О принципиально неразрешимых положениях в системе Principia Mathematica и родственных ей системах». Центральным пунктом его работы были формулировка и доказательство теоремы, которая сыграла фундаментальную роль во всем дальнейшем развитии математики, и не только ее. Речь идет о знаменитой теореме Геделя о неполноте. Наиболее распространенная, хотя и не вполне строгая ее формулировка утверждает, что «для любой достаточно сложной непротиворечивой системы аксиом существует утверждение, которое в рамках принятой аксиоматической системы не может быть ни доказано, ни опровергнуто». Тем самым Гедель дал отрицательный ответ на первое утверждение, сформулированное Гильбертом.

Одним их многочисленных следствий гипотезы Пенроуза может стать, в частности, вывод о принципиальной невозможности создания искусственного интеллекта на основе современных вычислительных устройств, даже в том случае, если появление квантовых компьютеров приведет к грандиозному прорыву в области вычислительной техники. Дело в том, что любой компьютер может лишь все более детально моделировать работу формально-логической, «вычислительной» деятельности человеческого сознания, но «невычислительные» способности интеллекта ему недоступны.

И если считать умение логически рассуждать основной характеристикой человеческого разума или, по крайней мере, главным его инструментом, то теорема Геделя прямо указывает на ограниченность возможностей нашего мозга.

С другой стороны речь может идти об ограниченности наших представлений о собственных ментальных возможностях. Многие специалисты полагают, что формально-вычислительные, «аристотелевские» процессы, лежащие в основе логического мышления, составляют лишь часть человеческого сознания. Другая же его область, принципиально «невычислительная», отвечает за такие проявления, как интуиция, творческие озарения и понимание. И если первая половина разума подпадает под геделевские ограничения, то вторая от подобных рамок свободна.

Заключение

Описанные выше проблемы искусственного интеллекта указывают на то, что крайне сложно на современном этапе развития (а может быть даже невозможно) создать реальную систему искусственного интеллекта, которая бы могла мыслить как человек.

Можно лишь создать систему, имитирующую работу человеческого мозга.

На данном этапе создаются системы интеллектуальной обработки данных.