И. И. Мечникова Институт Математики, Экономики и Механики Кафедра Теоретической Механики Реферат

| Вид материала | Реферат |

- И. И. Мечникова Институт математики, экономики и механики Кафедра менеджмента и математического, 246.65kb.

- Научный, 8.03kb.

- И. И. Мечникова Институт математики, экономики и механики Кафедра математического обеспечения, 900.66kb.

- Доктор технических наук, заведующий лабораторией физики прочности и механики разрушения, 418.09kb.

- Теоретическая механика, 55.27kb.

- Лекций: 34 Практических: 18 Лабораторных: 0 sm. 5 Сопротивление материалов и основы, 22.99kb.

- Механика Ньютона Какими задачами ограничиваются возможности механики Ньютона? закон, 34.74kb.

- Научная программа конференции. На конференции предполагается работа следующих секций:, 29.46kb.

- Использование методов голономной механики для определения собственных частот и форм, 264.8kb.

- Рабочая программа Наименование дисциплины «Механика» По специальности 261203. 65 Тпп, 260.39kb.

Министерство образования и науки Украины

Одесский Национальный Университет им. И.И.Мечникова

Институт Математики, Экономики и Механики

Кафедра Теоретической Механики

Реферат

Современное использование кластерных систем

Студента 6-го курса специальности 07.080301 “Механика” Малинского Александра Викторовича

Одесса 2006

В настоящее время кластерные технологии широко используются в качестве вычислительных систем и в качестве, так называемых, “систем высокой готовности”.

Системы высокой готовности.

Системы высокой готовности – системы, обеспечивающие высокую надежность обработки данных и способность ежесекундно обеспечивать пользователей оперативной и достоверной информацией. Ведущими поставщиками кластерных систем высокой готовности в наши дни являются фирмы Sun, IBM и HP.

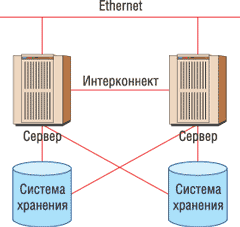

Типовая схема кластерной системы высокой готовности, изображенная на рисунке (1).

рис(1)

Подразумевает объединение двух или более серверов в целостную систему, снаружи видимую пользователями как единый сервер, исполняющий то или иное корпоративное приложение, например, СУБД. Для связи вовне и передачи данных от потребителей и к ним в большинстве случаев используется стандартное соединение Fast Ethernet или получающий все большее распространение стандарт Gigabit Ethernet. Между собой серверы общаются посредством так называемого интерконнекта — специальной выделенной сети для синхронизации состояний и посылки команд перезапуска заданий на резервном узле в случае обнаружения сбоев или отказов на основном. Взаимодействие с системами хранения организовано максимально гибко: можно использовать любые схемы и протоколы - от прямого подключения до решений NAS и SAN, присоединяемых по оптоволокну.

И еще один важный момент. Реальные кластерные системы высокой готовности строятся в одной из двух базовых архитектур - с разделением ресурсов (share something) или без разделения ресурсов (share nothing). В первом случае, благодаря внутренней логике промежуточного ПО задача заказчика "размазывается" по серверам, входящим в кластер, и на каждом сервере исполняется некоторая ее часть. Во втором случае задача заказчика целиком и полностью решается на головном узле системы, а второй сервер фактически играет роль горячего резерва, способного в любой момент времени подхватить "упавшее" приложение.

Вычислительные системы.

В качестве примера использования кластеров как высокопроизводительных вычислительных систем рассмотрим “Центр высокопроизводительных вычислительных кластерных технологий” механико-машиностроительного факультета Санкт-Петербургского Государственного Политехнического Университета.

В этом центре кластерные системы используются для вычислительных задач в следующих направлениях:

- Вычислительная механика

- Вычислительная газодинамика

- Численные методы и конечно-элементный анализ в механике деформируемого твердого тела

- Механика деформируемого твердого тела, механика композитов, механика разрушения, механика стержней, пластин и оболочек

- Общая механика

- Высокопроизводительные вычислительные системы и их применение

- Вычислительные кластерные технологии

- Математическое и компьютерное моделирование механических систем

- Вычислительные программные комплексы и параллельные вычисления

- Визуализация в научных исследованиях и виртуальная реальность в машиностроении

- Разработка алгоритмов и программ параллельных вычислений.

Также, в качестве вычислительного комплекса, компанией NS Labs был реализован проект по созданию 14-ти узлового кластера на базе технологий Intel и ОС Linux. Кластер установлен в крупном нижегородском научно-исследовательском институте и его основной задачей является решение задач, требующих больших вычислительных ресурсов для расчётов комплексных многомерных задач по эмулированию реальных процессов.

Другие примеры кластерных систем

В Москве функционирует центр кластерных технологий на базе кластера T-Forge32 c процессорами AMD Opteron.

При построении кластера T-Forge32 использовались технологии AMD64, позволяющие разрабатывать единую инфраструктуру 64-разрядной вычислительной обработки, полностью совместимую с традиционным набором команд x86.

рис(2)

Представленная модель кластера представляет собой 16 двухпроцессорных узлов на базе AMD Opteron 244, связанных коммуникационной средой.

рис(3)

Основные характеристики кластеров:

| | T-Forge64 | T-Forge32 | T-Forge16 | T-Forge8 |

| Тип процессора | AMD Opteron 244 1,8 ГГц | |||

| Кол-во процессоров | 64 | 32 | 16 | 8 |

| Кол-во модулей | 32 | 16 | 8 | 4 |

| Максимальный объем RAM | 512 Гб | 256 Гб | 128 Гб | 64 Гб |

| Пиковая производительность | 230,4 Гфлоп | 115,2 Гфлоп | 57,6 Гфлоп | 28,8 Гфлоп |

рис(4)

Особенностью работы института является комплексный подход в разработке решений от аппаратных средств до общесистемного ПО, включая вопросы безопасности, а также собственные разработки прикладных программ, инструментальных средств.

Кластеры и геофизика.

Компания R-Style осуществила поставки кластерных систем для геофизических вычислений на основе двухпроцессорных серверов на базе процессора Intel Xeon.

Серверы R-Style Marshall, входящие в кластеры, используют процессоры Intel® Xeon™, работают под управлением операционной системы Red Hat® Linux и являются платформой для работы программного обеспечения, выполняющего геофизические расчеты. В комбинации с ПО кластеры позволяют снизить время обработки сейсмических данных и обеспечивают получение более точных изображений земной поверхности, улучшая тем самым управление хранилищами сырой нефти для компаний нефтяной отрасли.

"R-Style Siberia" одной из первых в России осуществила внедрение решений для расчетов параметров земной коры на платформе Intel. Выбор данной аппаратной платформы позволил сэкономить заказчикам значительные средства в сравнении с применением аналогичных по производительности многопроцессорных серверных систем на основе RISC процессоров.

Кроме этого, кластерные вычислительные системы Intel могут использоваться для научных и промышленных приложений в самых разных областях - от нефтяной и аэрокосмической до финансовой и биоинформационной, - обеспечивая высочайшую производительность.

Кластеры в газовой области.

Очень актуально использование кластерных вычислений в газовой отрасли, где необходимо с высокой точностью учитывать визуализацию земной поверхности, обрабатывать большие объемы сейсмических данных и решать сложные задачи газодинамики.

Все объекты ОАО "Газпром" - предприятия по добыче, транспортировке, переработке, подземному хранению газа, разбросанные на огромной территории страны, объединены в единый производственный комплекс. Управление таким комплексом, поддержание жесткого технологического режима, абсолютно невозможны без создания единой и надежной сети связи отрасли. Система связи отрасли - одна из крупнейших корпоративных сетей России. Сегодня газовая отрасль располагает цифровой системой связи на уровне лучших мировых образцов.

Вычислительная система emCluster в электромагнитном моделировании.

Кластерные вычислительные системы позволяют значительно снизить время обработки данных при электромагнитном моделировании путём суммирования вычислительной мощности нескольких процессоров в единой вычислительной системе.

Система emCluster может быть сконфигурирована для работы как в сосредоточенном локальном кластере, так и в распределенной или объединенной вычислительной среде через глобальную сеть Wide Area Network (WAN) или через Интернет с использованием соединения Virtual PrivateNetwork (VPN). В отличие от традиционных кластеров, система может работать в гетерогенных вычислительных средах, вплоть до объединенных массивов компьютеров.

рис(5)

Кластерная вычислительная система, собранная в компании Sonnet.

рис(6)

Основными требованиями к первому собранному в компании Sonnet кластеру были: малая потребляемая мощность, малое тепловыделение и малый шум от вентиляторов, что важно в случае демонстрации системы на выставках. Логической отправной точкой для кластера с малой потребляемой мощностью стал центральный процессор от ноутбука. Кластер Sonnet (рис. 5) собран на процессорах Intel Pentium-M с тактовой частотой 1.8 ГГц. Несмотря на низкую тактовую частоту, процессоры Pentium-M обрабатывают больше команд за такт и имеют больший объём встроенной кэш-памяти, чем обычные процессоры Pentium 4. В итоге, производительность системы получается выше. На тестах, проведенных специалистами компании Sonnet, один процессор Pentium-M 1.8GHz по быстродействию сопоставим с процессором Pentium 4 3.4GHz. Про умножении на число 10 получается серьёзная вычислительная мощность: порядка 40 миллиардов операций в секунду. В дополнение к указанной производительности процессора, каждый блок был оснащен 2 гигабайтами оперативной памяти PC-3200 с рабочей частотой шины 400МГц. Для первого кластера компании Sonnet была использована материнская плата i855gme, одна из всего лишь трёх типов плат на рынке, поддерживающих процессор Pentium-M на момент создания кластера.

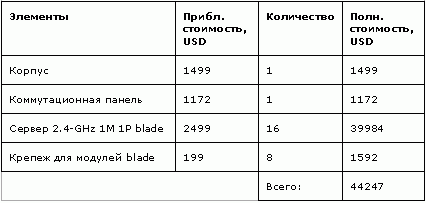

Примерный расчет стоимости кластера Sonnet

рис(7)

В каждом узле кластера имеется собственный жёсткий диск размером 40 Гбайт и двухсотваттный блок питания. Из эстетических соображений в систему были добавлены синие светодиодные индикаторы, но позднее оказалось, что это очень удобно, так как помогает обнаруживать неисправности с питанием. В этой таблице приведен приблизительный расчет стоимости кластера Sonnet. Легко видеть, что стоимость оборудования составляет около 10 000 долларов. Максимальный вклад в общее энергопотребление кластера вносят процессоры Pentium-M. Однако, если учесть, что Pentium-M с тактовой частотой 1.8 ГГц потребляет всего 21 Вт, а Pentium 4 с частотой 3.4 ГГц, потребляющим 100 Вт, то получается почти четырехкратное снижение потребляемой мощности. Измеренная во время работы потребляемая мощность одного полного вычислительного узла на процессоре Pentium-M составляет 55Вт . Кластер из 10 узлов потребляет менее 600 Вт, что находится в пределах допустимых норм для стандартной сети переменного тока. Меньшая потребляемая мощность, безусловно, также означает меньший нагрев, а значит снижение требований к отводу тепла. Шесть обычных высокооборотных вентиляторов были заменены двумя низкооборотными, что позволило снизить создаваемый при работе шум.

Конечно, это был первый кластер, построенный на процессорах Pentium-M. Он настолько уникален, что компания Intel купила одну из систем для испытаний.

Примерный расчет стоимости кластера на базе blade серверов.

рис(8)

Одноплатные blade серверы являются на сегодняшний день вершиной конструкторской мысли в аппаратной части кластеров нижнего и среднего ценового диапазона. В высшей степени оптимизированные, одноплатные серверы уменьшают занимаемое место и потребляемую мощность путём разделения ресурсов. Эти сверхтонкие блоки ставятся в специальный корпус, где уже разведено питание, сеть и имеются устройства хранения данных, и поддерживают возможность горячей замены. Каждому такому серверу необходимо иметь лишь материнскую плату, процессор и оперативную память. Однако, высокая цена комплектующих делает одноплатные серверы экономически обоснованными только при количествах свыше 40. В таблице 4 приведен приблизительный расчет стоимости 16-модульного сервера, занимающего в рэковой стойке место 6U (шесть 1U серверов).

Проект Blue Gene

О запуске проекта Blue Gene было официально объявлено 21 сентября 2000 года. Представители IBM заявили тогда о намерении вложить 100 миллионов долларов в создание нового суперкомпьютера, который смог бы выполнять квадриллион операций в секунду (петафлопс), что примерно в тысячу раз больше, чем знаменитая машина Deep Blue, выигравшая в свое время у чемпиона мира по шахматам Гарри Каспарова. Blue Gene был призван прийти на смену именно Deep Blue. Происхождение названия Blue Gene ("голубой ген") свидетельствует о первоначальном предназначении этого суперкомпьютера. Когда проект только стартовал, планировалось, что Blue Gene будет использоваться учеными для моделирования процесса создания из аминокислот белков протеинов по "инструкциям", хранящимся в ДНК. Это позволило бы понять причины возникновения различных заболеваний и выработать способы их лечения. Однако уже в ноябре 2001 года Blue Gene заинтересовалось одно из оборонных ведомств США, Министерство энергетики, после чего IBM подписала контракт с департаментом ядерной безопасности на поставку новой версии этого суперкомпьютера, Blue Gene/L, для исследований в области ядерных вооружений.

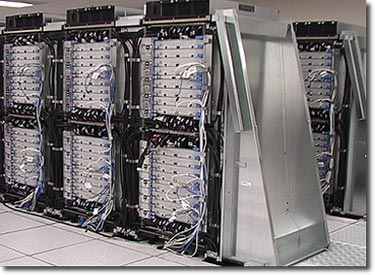

Новая машина, которая в настоящее время монтируется в Ливерморской национальной лаборатории имени Лоуренса, в ноябре 2005 года уже возглавляла рейтинг 500 самых мощных суперкомпьютеров мира - тогда ее производительность составила 70,7 триллиона операций в секунду. Компьютер состоял из 16384 двуядерных процессоров PowerPC 440 с тактовой частотой 700 МГц (из-за двуядерности использованных чипов в рейтинге говорится о 32768 процессорах). Для составления рейтинга 500 самых мощных компьютеров используется тест производительности Linpack, при котором каждое ядро занято вычислениями, однако во многих других случаях одно из ядер будет заниматься телекоммуникационными задачами.

рис(9)

Создание 65536-процессорного Blue Gene/L знаменует собой завершение второй стадии 100-миллионного проекта суперкомпьютера. По информации IBM, окончательный вариант Blue Gene/L будет состоять из 130000 процессоров, а его теоретическая пиковая производительность достигнет 360 терафлопс.

рис(10)

Первоначально предполагалось, что суперкомпьютер Blue Gene/L не будет использоваться в секретных проектах, однако в Ливермонской лаборатории считают, что он будет очень полезен в военных исследованиях. Этот компьютер использовался для моделирования взаимодействий 16 миллионов атомов в образце тантала, застывающего под давлением, однако Blue Gene/L нельзя применять для всех задач, для решения которых используются суперкомпьютеры. Кроме того, Blue Gene/L применялся в Национальной лаборатории Лос-Аламоса для изучения появления раковин в металле, при этом моделировалось в динамике взаимодействие более 2,1 миллиарда атомов.

И в заключение отметим планируемые решения различных задач с помощью кластерных систем.

Научно-исследовательский вычислительный центр МГУ им.Ломоносова, Институт программных систем РАН, компании Sun Microsystems, "Т-Платформы" и AMD подвели итоги конкурса на лучший проект использования высокопроизводительного кластерного решения среди образовательных и научных организаций России, Украины и Белоруссии. Первый приз конкурса- 10-узловой кластер T-Fire20 от "Т-Платформы" и Sun Microsystems - был присужден Химическому факультету МГУ за проект "Прототипы нано автомобилей на основе высокопроизводительных расчетов методами молекулярного моделирования". Второй приз, шестиузловой T-Fire12, получил Институт вычислительной математики РАН за проект "Параллельные технологии построения тензорного разложения для решения больших задач". Третий приз, четырехузловой кластер T-Fire8, был отдан АНО "Научный центр"ГДТ Софтвер Гроуп" из Тулы, представившему на конкурс шесть проектов по численному моделированию быстропротекающих процессов. Всего на конкурс было представлено 52 проекта от 39 вузов и научных институтов России, Украины и Белоруссии.