Кластер - это вычислительная машина, имеющая несколько процессоров и позволяющая задаче параллельно выполняться на них

| Вид материала | Документы |

- Лекция Основные классы вычислительных машин, 96.53kb.

- Волгоградская Государственная Сельскохозяйственная Академия Описание проекта Название, 107.58kb.

- Машина как средство познания себя, 640.44kb.

- Лекция Понятие информационно-вычислительных систем, 106.98kb.

- Ведение два класса ЭВМ. Принцип действия ЭВМ, 1873.09kb.

- Укиевлян всегда были основания гордиться инженерными достижениями своих земляков, 255.44kb.

- Палочки, 47.7kb.

- Доклад. Технология подготовки, 153.37kb.

- Сценарий "Новогоднее чудо", 772.92kb.

- Сценарий Новогоднего вечера в 9-11 классах «Любовь с первого взгляда», 67.83kb.

ИСПОЛЬЗОВАНИЕ КЛАСТЕРОВ В ОБРАЗОВАТЕЛЬНОМ ПРОЦЕССЕ РОССИИ И УКРАИНЫ

Кластер — это вычислительная машина, имеющая несколько процессоров и позволяющая задаче параллельно выполняться на них. Клиент взаимодействует с кластером так, как будто кластер является единым сервером, даже если он физически представляет собой объединение нескольких серверов. Кластерные конфигурации используются для обеспечения высокой готовности, упрощения управления и увеличения масштабируемости.

- ИНФОРМАЦИОННО-ВЫЧИСЛИТЕЛЬНЫЙ ЦЕНТР КИЕВСКОГО НАЦИОНАЛЬНОГО УНИВЕРСИТЕТА ИМЕНИ Т.Г. ШЕВЧЕНКО

Первые попытки запустить распараллеленную задачу на нескольких машинах были сделаны в апреле 1999 года Александром Олейниковым и Русланом Явдошаком на машинах компьютерного класса радиофизического факультета. Использовалась операционная система FreeBSD-3.1 и библиотека MPI. Сначала задача решалась на двух машинах, а со временем на шести. Возможностью распараллеливания задач заинтересовались. Сразу появились попытки распараллелить некоторые из численных методов, чтобы действительно ощутить "мощность" вычислительного комплекса. К тому времени стоял ряд задач из квантовой механики, которые требовали громоздких вычислений. Поэтому проблема распараллеливания задач такого рода была актуальной.

Появлялось все больше задач, которые требовали больших мощностей, поэтому в ноябре 1999 года на ИВЦ был создан официальный вычислительный кластер Киевского национального университета имени Тараса Шевченко, который состоял из четырех узлов, построенных на основе однопроцессорных рабочих станций с процессором PIII-450, оперативная память 128Мб, жесткий диск 12Гб. На протяжении 2000 года нагрузки на кластер возросли и вышли на довольно высокий уровень (до 600-1000%). Было решено провести модернизацию системы, что и было сделано в марте-апреле 2001 года в рамках программы поддержки высших учебных заведений корпорации ссылка скрыта при содействии украинского представительства Интел. В рамках проекта ссылка скрыта Киевскому университету предоставлен четыре двухпроцессорных сервера на основе процессора PIII-933. Серверы собраны и протестованны компанией ссылка скрыта на основе платформы ссылка скрыта.

Кластер Киевского национального университета имени Тараса Шевченко принадлежит к гетерогенным кластерам типа MOSIX. Система состоит из 14 двухпроцессорных узлов на базе Intel® PentiumIII-933MГц и 1ГГц и Intel® Xeon 2.4ГГц. В качестве служебной сети используется Gigabit Ethernet. На узлах установлена операционная система Linux на основе поставки RedHat 7.1 с Kernel - 2.4.21 и openMosix-1. Каждый узел кластера имеет одинаковую структуру каталогов и содержит одинаковый набор программного обеспечения, которое инсталлировано в те же каталоги. Основная модель программирования - MPI (Message Passing Interface), поддерживается также PVM (Parallel Virtual Machine).

Конфигурация узла

| На базе Intel® Pentium III 933MГц (4 узла)

Сетевая плата - ссылка скрыта (Gigabit Ethernet) | На базе Intel® Pentium III 1ГГц (4 узла)

Сетевая плата - ссылка скрыта (Gigabit Ethernet) |

| На базе Intel® Xeon 2.4ГГц (4 узла)

Сетевая плата - ссылка скрыта (Gigabit Ethernet) | На базе Intel® Xeon 2ГГц (2 узла)

|

Использование вычислительного кластера является свободным и бесплатным для сотрудников университета при условии соблюдения ссылка скрыта. Представители других учебных заведений Украины могут использовать ресурсы кластера по договоренности с ссылка скрыта.

2. КЛАСТЕР В ВОРОНЕЖСКОМ ГОСУДАРСТВЕННОМ УНИВЕРСИТЕТЕ

В 2002 г. на кафедре цифровых технологий ВГУ при поддержке гранта VZ-010 Фонда CRDF создан 20-процессорный высокопроизводительный вычислительный кластер в составе четырехпроцессорного сервера SUPERSERVER 8060 (4xCPU Pentium III Xeon, 700 MГц, 4 Гб SDRAM), четырех двухпроцессорных серверов SUPERSERVER 6010H (2xCPU Pentium-III, 1,13 ГГц, 1 Гб SDRAM), восьми рабочих станций (Pentium–4, 2,0 ГГц, 512 Mб RIMM). Пиковая производительность кластера – 28 Gflops. (Для сравнения – пиковая производительность некоторых других компьютерных кластеров: Томский государственный университет – 12 Gflops, Казанский государственный университет – 5,4 Gflops, Уральский государственный университет – 19 Gflops, Дальневосточное отделение РАН – 16,5 Gflops, Кемеровский государственный университет – 4 Gflops, Самарский научный центр РАН – 9 Gflops, Институт оптики атмосферы (Томск) – 20 Gflops, Институт астрономии РАН (Москва) – 29 Gflops, Нижегородский государственный университет – 45 Gflops, Казанский технологический университет – 12 Gflops). На кластере установлена операционная система Windows 2000. Узлы кластера первого уровня (четырех- и двухпроцессорные) связаны по протоколу Gigabit Ethernet, для связи остальных узлов реализован протокол Fast Ethernet.

|  |

Кластер включен в состав действующей региональной части российской ИОС (информационно-образовательной среды). Доступ к кластеру ВГУ после предварительной регистрации можно получить по Интернет-адресу: su.ru/clust. Доступ обеспечивается специально разработанной для этого системой, созданной на базе программного обеспечения Microsoft Internet Information Services. Зарегистрированным слушателям ФПКП (факультет повышения квалификации преподавателей) предоставляется возможность размещать создаваемые ими программы для выполнения на кластере через Web-интерфейс (браузер), дистанционно компилировать и исполнять их, а также просматривать любые файлы из своих каталогов, удалять их или изменять содержимое. Кроме того, при создании во время работы программы новых файлов, например, с результатами расчетов, они могут просматривать и эти файлы. Программы выполняются в пакетном (автоматическом) режиме без взаимодействия с автором или администратором. Результаты работы программы переносятся на компьютер пользователя средствами Web-браузера.

Применение в учебном процессе ФПКП методов математического моделирования на основе использования суперкомпьютера позволяет обеспечить высокий уровень повышения квалификации современных специалистов. Математическое моделирование становится интеллектуальным ядром не только информационных технологий, но и всего процесса информатизации общества. То, что математическое моделирование является неизбежной составляющей научно-технического прогресса, заставляет активизировать изучение его методов в системе повышения квалификации.

Объединение параллельного кластера и образовательного портала «Voronezh.OpeNet.ru» позволило создать условия для проведения на ФПКП сложных вычислительных экспериментов как в учебных, так и в научных целях. Применение удаленного доступа, обеспечиваемого Интернет–технологиями, дает возможность использовать кластер в учебном процессе и научных исследованиях не только в университете, но и в городе и регионе.

3. КЛАСТЕР ВЫЧИСЛИТЕЛЬНОГО ЦЕНТРА РОССИЙСКОЙ АКАДЕМИИ НАУК

С момента ввода в эксплуатацию в 2003 году вычислительный кластер Вычислительного центра имени А.А. Дородницына Российской академии наук (ВЦ РАН) используется не только для проведения научных расчетов, но и в образовательных целях. Кластер ВЦ РАН (ru/acluster/main.htm) с суммарной оперативной памятью в 32 GB и с суммарной памятью на жестком накопителе в 288 GB содержит восемь вычислительных узлов, связанных вычислительной сетью Myrinet 2000 (com) и управляющей сетью Ethernet 100Base-T. Вычислительные узлы кластера содержат по два процессора Intel Xeon DP 2600 MHz, 512 Kb cache. Управляющий узел кластера имеет процессор Intel Pentium 4 2260 MHz, 512 Kb cache, 533 MHz. На кластере установлена операционная система Linux RedHat 9, различные библиотеки взаимодействий API GM-2; MPICH-GM v.1.2.5-10, библиотеки высокого уровня ATLAS 3.6.0, Intel MKL 7.2.1 и параллельная библиотека ScaLapack. На кластере используется пакетная система очередей OpenPBS (ссылка скрыта), входящая в состав проекта OSCAR v 3.0 (ge.net/projects/oscar/). Для работы студентов в системе очередей выделена специальная очередь shortest (время выполнения до 1 часа), при этом реализована политика выполнения в первую очередь задач с наименьшим временем выполнения.

Основываясь на характеристиках имеющегося в ВЦ РАН вычислительного кластера, был специально разработан годовой курс обучения «Параллельное программирование в интерфейсе MPI», который излагается студентам 5 курса Московского физико-технического института (государственного университета), обучающимся на базовой кафедре «Математическое моделирование сложных процессов и систем» в ВЦ РАН. Курс рассчитан на начинающего пользователя Message Passing Interface - интерфейса передачи сообщений MPI - студента или специалиста, не знакомого с методами программирования для параллельных ЭВМ, однако владеющего последовательным программированием на языке программирования С в среде Windows или Linux. В настоящее время в локальной сети ВЦ РАН помещен рабочий вариант полной электронной версии курса, который непрерывно совершенствуется. Некоторые из работ появляются в открытом доступе.

С одной стороны, данный курс MPI следует международным образцам достаточно полного изложения MPI, которые даны в западных учебных курсах, например, в курсе Cornell Theory Center (CTC). С другой стороны, данный курс MPI специально предназначен для специалистов в математическом моделировании сложных процессов и систем. Поэтому к стандартным упражнениям апробированных учебных курсов здесь добавлены упражнения, связанные с применением параллельных вычислений в математическом моделировании.

4. СОЗДАНИЕ ИНФОРМАЦИОННОЙ ИНФРАСТРУКТУРЫ НАУКИ И ВЫСШЕГО ОБРАЗОВАНИЯ В РЕСПУБЛИКЕ ТАТАРСТАН

Проект КазНЦ РАН "Создание центра высокоскоростной обработки информации для нужд институтов Казанского научного центра Российской академии наук и высших учебных заведений г. Казани" реализован в рамках ФЦП «Интеграция». Созданный в рамках данного проекта вычислительный кластер на базе серверов фирмы COMPAQ с 9-ю процессорами ALPHA имеет производительность порядка 6 Гигафлоп и обеспечивает удаленный доступ через сеть Internet для выполнения расчетов.

На сегодняшний день вычислительный кластер КазНЦ РАН наиболее востребованным оказался со стороны химиков и физиков, занимающихся исследованиями механизмов протекания химических реакций, электрохимических процессов, электронной структуры молекул и прежде всего за счет существования доступных программ, основанных на методах квантовой химии и ориентированных на многопроцессорные вычислительные системы.

Учитывая исключительную значимость методов численного моделирования для научных исследований и развития технологий современного общества в области органической и неорганической химии и молекулярной физики, а также первые положительные результаты использования вычислительных ресурсов Центра высокоскоростной обработки информации КазНЦ РАН, совместно с КГТУ/КХТИ и КГУ, в рамках ФЦП "Интеграция" созданы два вычислительных кластера на базе упомянутых вузов. Эти кластеры представляют собой вычислительные классы рабочих станций с процессорами AMD Athlon, объединенных между собой через коммутаторы ETHERNET линиями пропускной способностью 100 и 1000 Мегабит/сек и предназначены для проведения расчетов в научных исследованиях, подготовки и переподготовки научных сотрудников НИИ и вузов в области параллельных вычислений, а также для внедрения в учебный процесс тематики технологий параллельных расчетов и проведения практических занятий студентов, изучающих методы квантовой химии. Оба кластера через научно-образовательную сеть передачи данных обеспечиваются доступом к вычислительному Центру КазНЦ РАН и смогут использовать его ресурсы.

5. СВЕДЕНИЯ О КЛАСТЕРЕ ВЫЧИСЛИТЕЛЬНОГО ЦЕНТРА ДАЛЬНЕВОСТОЧНОГО ОТДЕЛЕНИЯ РОССИЙСКОЙ ВКАДЕМИИ НАУК

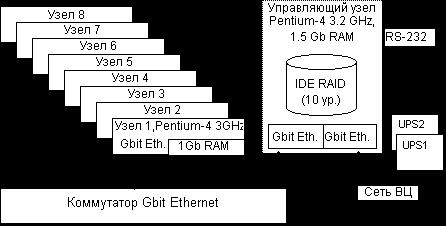

Вычислительный кластер ВЦ ДВО РАН состоит в настоящее время из 9 рабочих станций. Узлами кластера служат бездисковые высокопроизводительные рабочие станции, построенные с использованием следующих комплектующих: процессор Pentium-4 3 ГГц, материнская плата i875PE, двухканальная память DDR400 объема 1 Гб. Управляющий узел кластера укомплектован процессором Pentium-4 3.2 ГГц, памятью 1.5 Гб, IDE RAID контроллером, работающем в режиме 10 (с защитой данных зеркалированием) с 4 дисками по 200 Гб.

Сетевое оборудование Gbit Ethernet: коммутатор и интегрированные сетевые адаптеры. Источники бесперебойного питания Smart-UPS 1500 подключены к ОС.

Используется свободно распространяемое программное обеспечение:

Операционная система RedHat Linux 9.

Программные средства распределенных вычислений стандарта MPI: пакет LAM.

Языки программирования: C, C++, ФОРТРАН 77.

Мониторинг кластера выполняется с помощью программных средств GANGLIA.

По результатам теста High Performance Computing Linpack Benchmark (HPL 1.0) максимальное значение производительности на 9 узлах составило 35.5 Gflops.

6. КЛАСТЕР T-Edge36 ДЛЯ ЮЖНО-УРАЛЬСКОГО ГОСУДАРСТВЕННОГО УНИВЕРСИТЕТА

В декабре 2004 года компания "Т-Платформы" поставила 18-узловой кластер T-Edge36 на базе 36 процессоров Intel Xeon с технологией Intel EM64T в Южно-Уральский государственный университет.

Кластер T-Edge36 явился первой в России кластерной системой на базе новых 64-разядных процессоров Intel Xeon EM64T, обеспечивающей существенный прирост производительности по сравнению с решениями Intel предыдущего поколения. Установленный кластер использует передовые технологии высокоскоростной передачи данных InfiniBand и системной шины PCI Express 8x.

Основные технические характеристики:

- 18 узлов на базе 36 процессоров Intel Xeon EM64T 3.2GHz

- 36GB оперативной памяти, 1440GB дисковой памяти

- системная сеть InfiniBand 4х (PCI-Express), управляющая сеть Gigabit Ethernet

- форм-фактор 4U

- пиковая производительность 230.4GFlops, реальная - 186.6GFlops (81% от пиковой)

- операционная система SUSE Linux Enterprise Server 9.0

Южно-Уральский государственный университет входит в десятку крупнейших образовательных учреждений России. Вычислительный кластер T-Edge36 используется университетом для решения широкого спектра фундаментальных и прикладных задач, в числе которых:

- моделирование структур и свойств материалов методом первопринципной молекулярной динамики в интересах медицинской, химической электротехнической промышленности

- расчет зонной структуры фотонных кристаллов с целью создания материалов с принципиально новыми оптическими свойствами

- моделирование механического поведения конструкций, в том числе анализ динамической прочности оборудования с внедрением на заводах Челябинска

- задачи тепло-массообмена и газовой динамики (ракетные и авиационные двигатели, энергетические установки, ядерные реакторы и др.)

- задачи линейного программирования большой размерности (экономическое планирование, прогнозирование финансовых рисков, оптимальное управление)

- параллельные системы баз данных для иерархических кластерных архитектур и Grid-систем (научные базы данных, электронная коммерция, электронные библиотеки и мультимедиа-архивы) и др.

7. КЛАСТЕР T-Edge64 ДЛЯ КОМПАНИИ «САРОВСКИЕ ЛАБОРАТОРИИ»

В феврале 2005 года компания "Т-Платформы" поставила 32-узловой кластер T-Edge64 на базе 64 процессоров Intel Xeon с технологией Intel EM64T для компании "Саровские лаборатории" в рамках Программы Партнерства Международного научно-технического центра.

Компания "Саровские Лаборатории" (г. Саров, Россия) является научно-инженерным предприятием, специализирующимся на компьютерных расчетах прочности и термогазодинамики различных конструкций, сооружений и устройств с использованием программных комплексов ANSYS, LS-DYNA, STAR-CD. Кластер T-Edge64 приобретен для решения задач оптимизации теплопроизводительности водо-водяных реакторов атомных электростанций при помощи инженерного программного пакета STAR-CD в интересах Департамента Энергетики США. Проведенные компьютерные расчеты позволят уменьшить гидравлические потери жидкости, отводящей тепло от активной зоны реакторов.

К

онфигурация кластера T-Edge64 была оптимизирована для задач проекта "Саровских лабораторий". Использование технологии Gigabit Ethernet в качестве интерконнекта позволило создать экономичное и надежное решение, при этом обеспечив необходимый уровень эффективности работы программного пакета STAR-CD. Для быстрого доступа всех вычислительных узлов к общим данным в кластере предусмотрен NAS объемом 1Tb.

онфигурация кластера T-Edge64 была оптимизирована для задач проекта "Саровских лабораторий". Использование технологии Gigabit Ethernet в качестве интерконнекта позволило создать экономичное и надежное решение, при этом обеспечив необходимый уровень эффективности работы программного пакета STAR-CD. Для быстрого доступа всех вычислительных узлов к общим данным в кластере предусмотрен NAS объемом 1Tb. Основные технические характеристики:

- 32 узла на базе 64 процессоров Intel Xeon EM64T 2.8GHz

- 64GB оперативной памяти, 8ТB дисковой памяти

- системная сеть Gigabit Ethernet, управляющая сеть Gigabit Ethernet

- форм-фактор 2U

- пиковая производительность 358.4GFlops, реальная - 219.2GFlops (61.2% от пиковой)

- операционная система SUSE Linux Enterprise Server 9.0